La technologie n’est jamais neutre

Un algorithme n’est fiable que dans la mesure où les données et les principes qui l’ont entraîné le sont. Dit autrement : il perpétue les biais de ses créateurs.

Mystérieusement placés au centre des technologies et des discussions, « les algorithmes » seraient les garants d’un traitement automatisé, neutre et efficient de l’information. Quelque chose de très technique et complexe, auquel il faudrait accorder une confiance aveugle.

Pedro Domingos, professeur de l’Université de Washington, les définit pourtant simplement comme une « suite d’instructions » qu’un programme informatique suit. L’algorithme de Google définit ce qui apparaîtra en tête de vos résultats de recherche. Celui de Facebook, quels contenus vous verrez dans votre fil d’actualités. Mais il existe d’autres types d’algorithmes, comme par exemple... celui qui permet à votre lave-vaisselle de savoir quand passer du lavage au séchage.

Cette « suite d’instructions » (si il se passe ceci, alors l’instruction suivante est cela) peut être extrêmement laborieuse lorsqu’elle est écrite et enrichie manuellement. C’est pourquoi est apparu le « machine learning », ou quand « le programme apprend à écrire tout seul ses propres instructions ». Le programmeur fournit un ensemble de données, définit le résultat qu’il souhaite obtenir, et laisse le programme trouver le meilleur chemin (et les meilleures règles) pour aller du point A au point B.

Et par « meilleur » s’entend... le chemin le plus adapté aux instructions qu’on lui a données. Le résultat est donc mécaniquement une extrapolation de ce que l’opérateur aura injecté.

« Tu y trouveras ce que tu y apporteras »

Dans l’Empire contre-attaque (peut-être le meilleur des films Star Wars...), Luke doit poursuivre son initiation en s’enfonçant dans une caverne envahie par le côté obscur de la Force. Quand il demande à son vieux maître ce qu’il va y trouver, Yoda lui répond : « ce que tu y apporteras ».

Il en va donc un peu de même pour les algorithmes omniscients qui nous gouvernent : ils ne sont que le reflet de leurs créateurs. Et si pour un algorithme traditionnel, il faut uniquement s’inquiéter des biais du programmeur, alors pour du machine learning, il faut en plus se soucier des données qui auront nourri la réflexion.

À la source, il est intéressant de regarder très concrètement qui donne leurs instructions aux algorithmes qui nous gouvernent. En 2007, à un moment où ce genre de discours était loin d’être la norme, Adil Dash, PDG de Glitch et co-fondateur d’un outil d’analyse des réseaux sociaux, pointait déjà du doigt le « club de vieux garçons » qu’était le monde de la tech et à quel point l’uniformité des profils ne pouvait que « miner la pertinence des solutions produites ».

13 ans après, malgré les quelques progrès accomplis, le portrait est encore plutôt monochrome. 26,5% des employés américains d’Amazon s’identifient comme noirs ou afro-américains, or seuls 8% occupent un poste d’encadrement. Les employés de Google sont à 67% des hommes. Pire : la culture « tech » s’est révélée au cours des années extrêmement masculiniste, perpétuant préférences et comportements. Le témoignage de Susan Fowler en 2017, alors en poste au sein d’Uber, en reste un témoignage glaçant.

Faut-il donc s’étonner que le portail publicitaire de Google suggère des contenus pornographiques pour les termes « Black girls »,« Asian girls », et « Latina girls » - mais pas pour « White girls » ? Que les algorithmes utilisés dans le domaine médical aux États-Unis aboutissent à refuser la greffe de rein d’un patient noir au motif qu’il en aurait « moins besoin » ?

Trop peu fiables... par rapport à ce qu’on leur demande

Même en l’absence de biais systémique, les algorithmes actuels semblent très limités - beaucoup trop en tout cas pour le pouvoir qu’on leur donne. Dans une enquête fouillée sur le marché de la location immobilières aux États-Unis, The Markup liste les erreurs commises par les logiciels « d’analyse préventive des locataires » - un marché déjà évalué à 1 milliard de dollars. Interviewée, Samantha Lee Johnson raconte comment sa demande de location en Oregon a été refusée par un propriétaire après que son logiciel a fait remonter une dizaine de crimes et d’infractions à son nom. Un historique issu du mélange de 4 homonymes - et d’une personne ayant utilisé indûment le même patronyme...

Plus structurellement, 40 chercheurs de différents services de Google ont publié une étude pointant l’échec des modèles d’apprentissage automatique. En cause : un problème méthodologique, celui de la « sous-spécification ». Alex d’Amour, qui a dirigé cette étude, en résume les conséquences ainsi : « nous en demandons beaucoup plus à nos modèles que ce que nous sommes réellement capables de fournir ». Et de continuer : « nous découvrons des spécifications [manquantes] seulement quand le modèle échoue dans la vraie vie ».

Rassurant non ? Quand on sait combien de décisions et de tâches sont déjà confiées aux algorithmes, de la surveillance des populations à celle de notre lieu de travail.

En attendant : amener les opérateurs à s’intéresser aux résultats, plutôt qu’à se défausser sur les moyens

Il est peut-être temps de déplacer la responsabilité, poussée jusque là entre les mains de l’utilisateur final (nous), aux opérateurs eux-mêmes. Et de mettre un frein aux argumentaires dignes de la NRA (National Rifle Association, association de lobbying pro-armes aux États-Unis) : la technologie (comme les armes) porte en elle-même ses propre danger. Et il est pervers de dire que seule la personne qui appuie sur la gâchette est responsable de ce qui se passe à l’autre bout du canon.

Des chercheurs de l’Université de Stanford proposent ainsi un « nouveau paradigme » à destination des institutions financières, accusées d’utiliser les asymétries en termes d’information et d’exploitation des données à leur seul profit. Ils proposent d’intéresser les établissements non plus (seulement) au profit réalisé mais à la « santé financière » globale de leurs clients. Les ont-ils fait progresser dans la manière de gérer leur argent ? Dans la planification de leurs dépenses ? Dans le contrôle de leur endettement ?

Plutôt que de se servir de leurs données pour émettre des indicateurs de contrôle et de décision à l’usage exclusif de leurs conseillers, il s’agirait de mettre leurs outils au service d’un bien global, dont tout le monde (et l’économie en premier lieu) sortirait gagnant. Et donc de donner à leurs algorithmes que l’on sait maintenant largement biaisés (fondamentalement et méthodologiquement) le recul et la contextualisation dont ils manquent cruellement - à l’échelle d’une société ou d’une vie.

Les auteurs ne se font pas d’illusions et font de l’intervention de la puissance publique régulatrice un passage obligé. Mais avec l’objectif de donner la première impulsion au système. Et de déplacer le mécanisme d’apprentissage à l’échelle d’une société toute entière, à travers le partage et la transparence des données. N’est-ce pas ce qu’Alex D’Amour appelle de ses vœux en réclamant « plus d’informations, issues du monde réel » pour pouvoir mieux entraîner ses modèles ?

Retrouver le potentiel positif des technologies

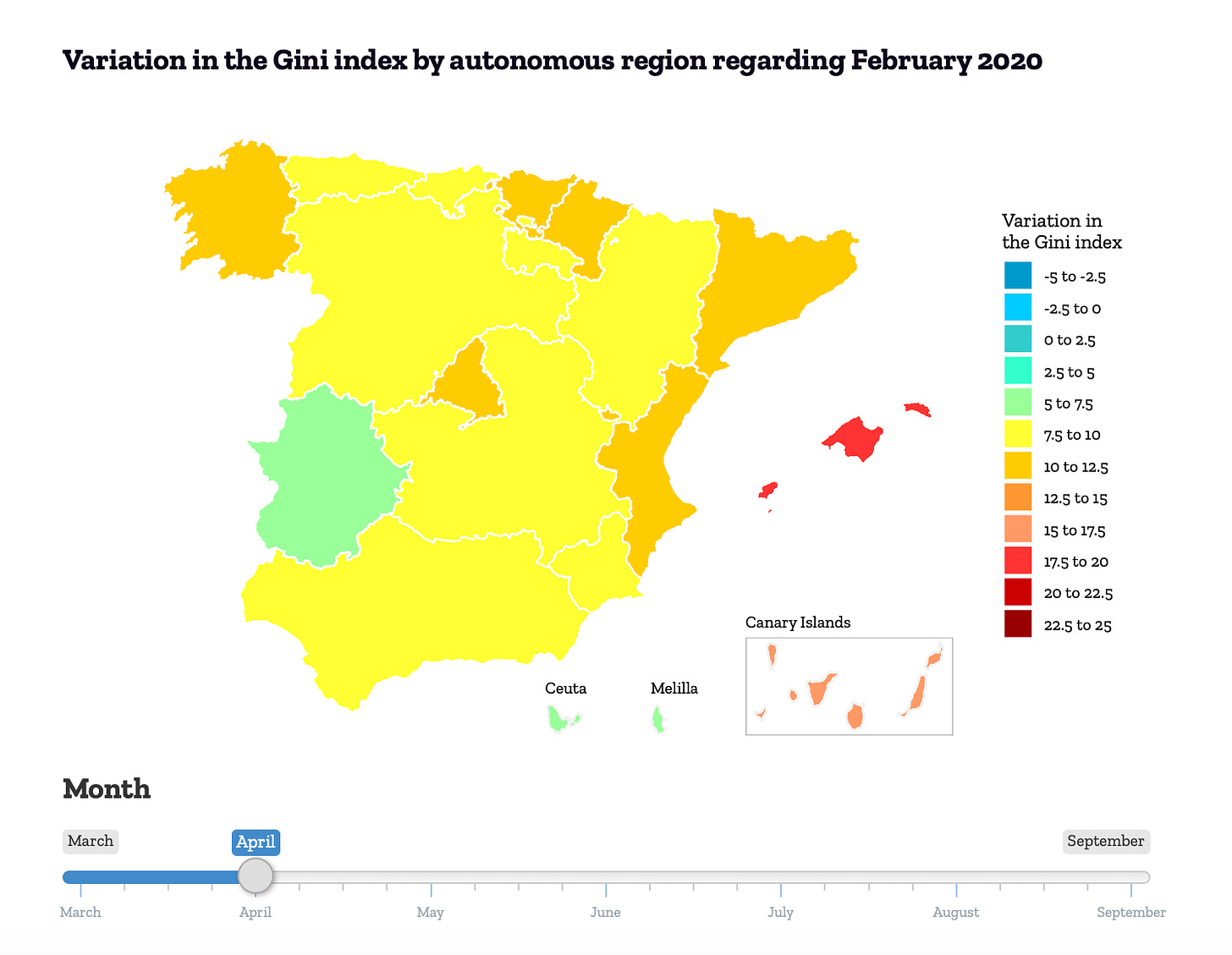

En Espagne, CaixaBank a travaillé avec des organismes de recherche pour entraîner ses modèles de données financières à la production d’un tableau de bord national des inégalités. Un outil de mesure et de pilotage, actualisé quasiment en temps réel, mis à disposition du public et des institutions. Car les perspectives d’utilisation par la puissance publique apparaissent nombreuses : analyse de l’efficacité des politiques, identification des populations ou des régions à cibler en priorité...

Mêmes données, autre application : dans sa lutte contre la COVID-19, le gouvernement australien s’essaie au contact tracing en remontant les flux des informations de paiement. Ou quand l’historique des achats (avec tous les gardes-fous qui s’imposent...) permet d’aider à résoudre un enjeu public de santé.

Bien sûr, on peut aussi faire un tout autre choix. Les mêmes données, toujours elles, ont aussi donné naissance à la vague des services « achetez maintenant, payez plus tard » (« Buy now, pay later » ou BNPL), autrement dit le surendettement à portée de main. Klarna, dorénavant évaluée à plus de 10 milliards de dollars, indique ainsi être capable d’évaluer votre capacité d’endettement à la volée au travers d’une « analyse douce » (sic) - mais particulièrement opaque.

Ce n’est donc pas un hasard si dans cette approche profondément décorrélée de la transparence et du bien-être de ses clients, le discours commercial officiel pare à nouveau « l’algorithme » des ses atours divins :

Notez que ni l’entreprise ni les programmeurs et encore moins le service après-vente ne sont donc susceptibles de prendre leurs responsabilité : la décision vient d’un programme informatique qui puisqu’il est « automatisé » n’obéirait à aucune autre logique que la sienne. C’est faire bien vite abstraction du modèle économique qui leur a permis récemment de lever 650 millions de dollars. On peut supposer que les investisseurs ont eu, eux, un peu plus de réponses que les clients que la plate-forme promet de servir.

Pour recevoir les prochaines publications, vous pouvez 👋 laisser votre email